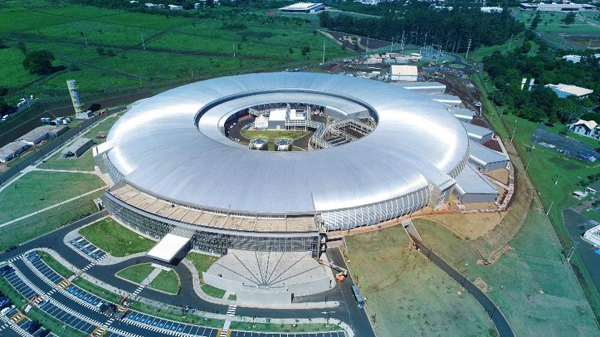

同步辐射光源是强大的设施,通过加速电子在受控光束中发射光,产生各种“颜色”或波长的光(从红外到X射线)。像能源部劳伦斯·伯克利国家实验室(Berkeley Lab)高级光源这样的同步加速器,能让科学家使用这种光以各种方式探索样品,范围从材料科学、生物学和化学到物理和环境科学。研究人员已经找到了升级这些机器的方法,以产生更强、更聚焦、更一致的光束,从而能够在广泛的样本类型中进行新的、更复杂和详细的研究。

解决一个数十年的问题

但是一些光束特性仍然表现出性能的波动,这对某些实验提出了挑战。其中许多同步加速器设备为数十个同时进行的实验提供不同类型的光。并且在这些单独的光束线上增强光束属性的小调整可以反馈到整个设施整体光束性能中。同步加速器的设计者和操作员几十年来一直在与各种方法搏斗,以补偿这些波动中最顽固的部分。现在,伯克利实验室和加州大学伯克利分校的一个大型研究团队,已经成功地证明了机器学习工具如何通过调整来提高实验光束大小的稳定性。

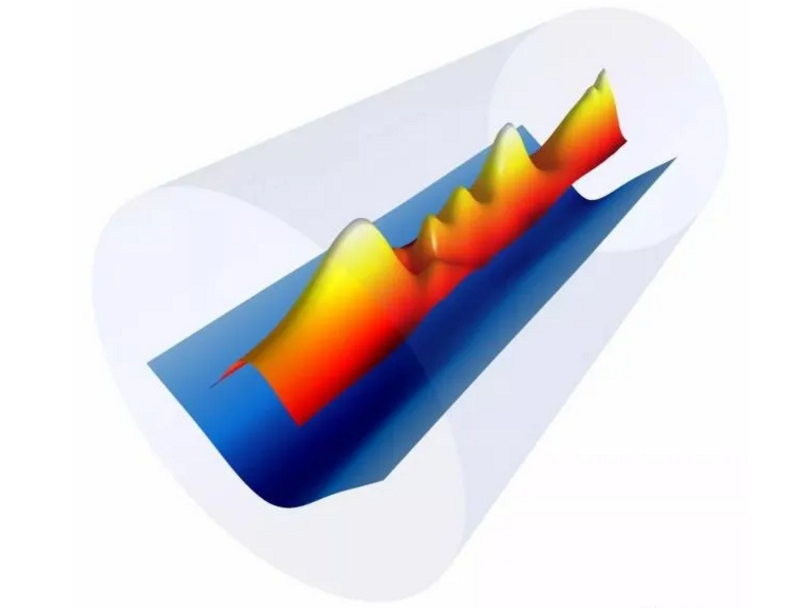

这些调整在很大程度上抵消了这些波动,如以亚微米(低于百万分之一米)的精度将其从几%的水平降低到0.4%,其研究成果发表在《物理评论快报》期刊上。机器学习是人工智能的一种形式,其中计算机系统分析一组数据以构建解决复杂问题的预测程序。ALS中使用的机器学习算法被称为“神经网络”,因为它们被设计为以一种松散地类似于人脑功能的方式识别数据中的模式。在这项研究中,研究人员将来自ALS的电子束数据(包括用于从电子束产生光磁性设备的位置)输入神经网络。

具有全球性影响

神经网络识别该数据中的模式,并确定不同的器件参数如何影响电子束的宽度,机器学习算法还建议对磁铁进行调整,以优化电子束。由于电子束的大小反映了磁铁产生的光束,因此该算法还优化了用于研究ALS材料特性的光束。在ALS上的成功演示表明,该技术一般也可以应用于其他光源,并且将特别有利于通过升级ALS(称为ALS-U项目)而实现的专业研究。伯克利实验室(Berkeley Lab)下属机构西村博史(Hiroshi Nishimura)说:这就是它的美妙之处,无论加速器是什么,无论传统解决方案是什么,这个解决方案都可以在此之上。

ALS主任史蒂夫·凯文(Steve Kevan)表示:这对ALS和ALS-U来说是一个非常重要的进步。几年来,X射线显微镜图像中的伪影一直存在问题。这项研究提出了一种基于机器学习的新前馈方法,它在很大程度上解决了这个问题。ALS-U项目将把光束的窄焦点从大约100微米水平提高到10微米以下,同时也对一致、可靠的光束特性提出了更高要求。机器学习技术建立在自1993年ALS启动以来几十年来改进的传统解决方案上,并且依赖于沿ALS环不断调整磁体,实时补偿各个光束线上的调整。

成功测试

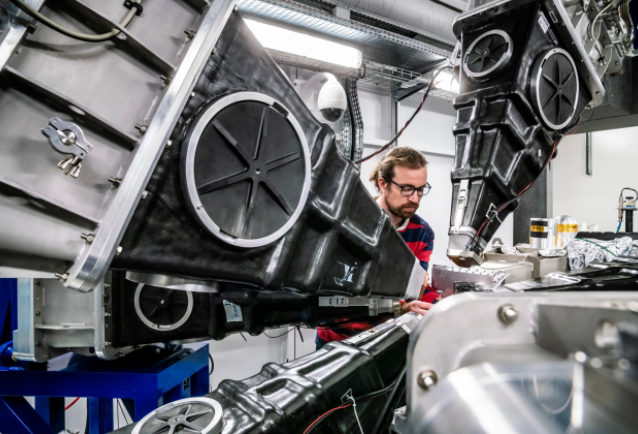

今年早些时候,研究人员在ALS环周围的两个不同地点成功测试了该算法,ALS其他用户进行新算法测试实验,并要求对任何意想不到的性能问题提供反馈。ALS的博士后研究员C·内森·梅尔顿(C.Nathan Melton)说:在用户操作方面进行了一致的测试。机器学习研究首席研究员、ALS加速器运营与开发的副手西蒙·利曼(Simon Leemann)说:对测试没有任何负面反馈,研究团队使用其中一条监测光束线是不断测量加速器性能的诊断光束线,另一条是实验正在积极运行的光束线。

具有活跃实验的光束线(beamline 5.3.2.2)使用了一种被称为扫描透射X射线显微镜(STXM)的技术,那里的科学家报告说在实验中改善了光束性能。机器学习小组注意到,增强的光束性能也非常适合先进的X射线技术,如排版印刷,它可以将样品的结构分解到纳米级;以及X射线光子相关光谱(XPCS),这对于研究没有均匀结构高浓度材料的快速变化非常有用。其他需要可靠、高度聚焦恒定强度光束与样品相互作用的实验也可以从机器学习增强中受益。

打开人工智能的“黑匣子”

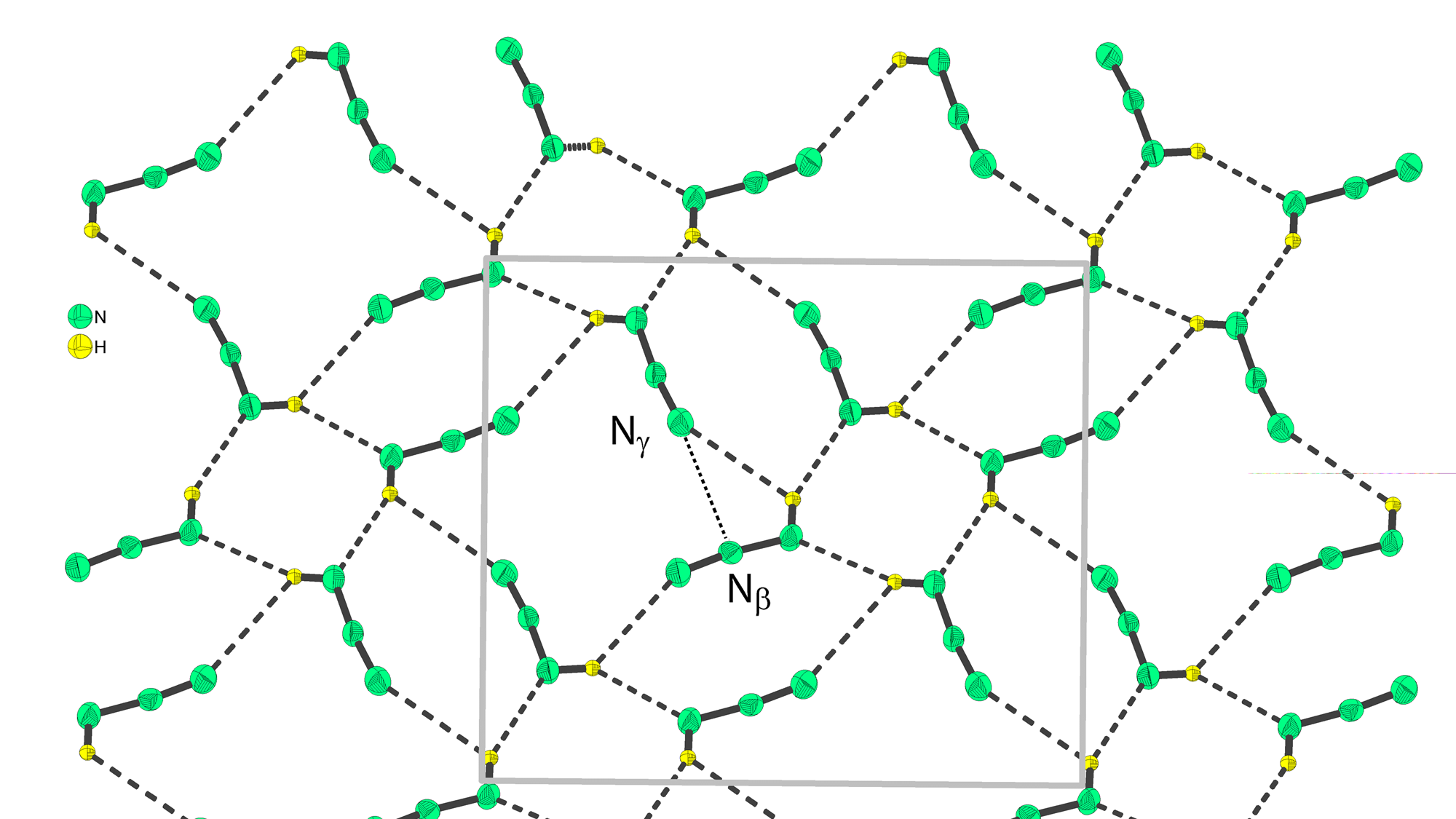

随着对样品的小面积扫描,实验要求变得越来越苛刻,所以必须找到新的方法来纠正这些不完美之处。光源是一直在努力解决的核心问题,以及机器学习工具所解决的问题,是在光束线源点处波动的垂直电子束尺寸。源点是光源处的电子束发射,到特定光束线实验光的点,虽然电子束在这一点上的宽度是自然稳定,但它的高度(或垂直源大小)可以波动。这一努力克服了最初对机器学习提高加速器性能可行性的怀疑,并打开了此类工具如何产生真正效益的“黑匣子”。

这不是一个传统上属于加速器社区的工具,研究成功地将来自两个不同社区的人聚集在一起,解决了一个非常棘手的问题。机器学习从根本上需要两件事:问题需要可重现,需要大量的数据。数据显示,当在各个光束线上进行调整时,电子束性能中出现了微小光点,并且该算法找到了一种方法来调整电子束,使其比传统方法更好地抵消了这种影响这个问题由大约35个参数组成,这真的太复杂了,神经网络一旦被训练就做了什么,它能提供了一个预测,如果它根本不做任何事情来纠正它,那么机器中的源大小会发生什么情况。

在这个模型中有一个额外参数,描述了在某种类型磁铁中所做的改变如何影响源尺寸。所以下来要做的就是选择参数,根据这个神经网络预测,产生研究想要创建的光束尺寸,并将其应用到机器上。算法指导的系统现在可以以每秒10次的速率进行校正,尽管每秒三次似乎足以提高这个阶段的性能。机器学习团队从能源部获得了两年资金,以便与SLAC国家加速器实验室的斯坦福同步辐射光源合作,开展这个和其他机器学习项目。研究人员表示:人工智能这个流行词似乎已经在研究界流行了很多年,不过,这一次它似乎终于变成了真实的东西。